Artículo publicado en el journal International Journal of Physical Exercise and Health Science for Trainers del año 2018.

Publicado 9 de febrero de 2018

Entrevista a Luis Sánchez Medina, a propósito de la publicación de la Carta al Editor de Naclerio & Larumbe-Zabala (2018) y respuesta asociada (Sánchez-Medina et al., 2018) en la revista Sports Medicine International Open.

Ambas publicaciones son de acceso libre y gratuito y están disponibles (en inglés) en:

https://www.thieme-connect.com/products/ejournals/issue/10.1055/s-007-35335

Luis Sánchez es doctor en Ciencias de la Actividad Física y del Deporte y especialista en Alto Rendimiento Deportivo; es el creador del T-FORCE System, un instrumento para la evaluación y el control del entrenamiento de fuerza. Actualmente trabaja como Técnico Superior de Deportes en la Unidad de Asistencia al Deportista del Centro de Estudios, Investigación y Medicina del Deporte (CEIMD) del Gobierno de Navarra, en Pamplona. Es coautor, junto con Juan José González Badillo, Fernando Pareja y David Rodríguez, del libro “La velocidad de ejecución como referencia para la programación, control y evaluación del entrenamiento de fuerza” (2017), texto disponible en:

https://www.libreriadeportiva.com/libro/la-velocidad-de-ejecucion-como-referencia-para-la-programacion-control-y-evaluacion-del-entrenamiento-de-fuerza_71043

Así como, en su versión en inglés, en: http://www.vbtraining.net/index.html

Tal como vemos en la carta al editor, pero siendo algo que también podemos encontrar en algunos foros divulgativos y “científicos”, se intenta cuestionar la fiabilidad de las ecuaciones de regresión lineal utilizadas para la estimación de la 1RM que su grupo publicó en el año 2010 y en adelante para los ejercicios de press banca y squat. Aunque en la carta podemos encontrar una clara y contundente respuesta ¿qué podría añadirse para todos aquellos que se encuentren con algunas afirmaciones que cuestionen estas fórmulas?

En primer lugar creo que hay que aclarar que una ecuación lineal (y = ax + b) no es más que un caso particular de una ecuación polinómica de segundo grado (y = ax2 + bx + c) donde el factor “a” es cero. Una ecuación de segundo grado es una parábola, una curva. La relación fuerza-velocidad en el músculo responde mejor a una curva que a una línea recta, como está descrito desde hace décadas en los textos de fisiología muscular y del ejercicio. Dicho esto, en nuestros estudios hemos empleado ecuaciones de ajuste cuadráticas porque la mayoría de las veces dichas funciones ajustaban mejor a las parejas de datos carga-velocidad (ya sea velocidad media –VM– o velocidad media de la fase propulsiva –VMP–). Así lo han indicado los tests estadísticos realizados. Por ejemplo, en el artículo pionero realizado con el ejercicio de press banca (González-Badillo & Sánchez-Medina, 2010), el modelo preferido para ajustar los datos carga-velocidad (1596 pares de datos) fue el cuadrático, tanto para la VM como para la VMP. Es cierto que el coeficiente “a” es de una magnitud muy pequeña (lo cual indica una pequeña curvatura) pero ¿por qué no emplear un ajuste cuadrático si es el que mejor refleja la realidad medida? A lo largo de los últimos años hemos realizado miles de tests progresivos con cargas en numerosos ejercicios de entrenamiento de fuerza; en la inmensa mayoría de los casos el ajuste cuadrático es algo superior al lineal. No hay que darle más vueltas.

En el estudio de la sentadilla al que hace referencia esta carta al editor (Sánchez-Medina et al., 2017), el coeficiente de determinación (R2) medio de los 80 tests progresivos con cargas analizados fue de 0,995 tanto para la VM como para la VMP, con un error típico de estimación inferior a 0,06 m/s. Esto roza la perfección, cosa que, en una disciplina como las Ciencias del Deporte, creo que lo dice todo. No se puede hilar más fino. Además de estas consideraciones, lo más importante es que las ecuaciones publicadas por nuestro grupo vienen siendo utilizadas desde hace años en la práctica del entrenamiento de fuerza por muchísimos deportistas y, día tras día, la realidad y la experiencia empírica confirma su validez.

Puede ocurrir que cuando se mide la velocidad conseguida antes pocas cargas (por ejemplo, sólo de 3 a 5) que no cubren del todo el posible espectro de cargas (desde las muy ligeras hasta las muy altas), una ecuación lineal se ajuste también muy bien a los datos. Las diferencias son muy pequeñas y no tienen mayor importancia (aunque parece que algunos han visto aquí una oportunidad para la discusión y el debate).

Personalmente, me parece, por tanto, una cuestión estéril ahondar más en este punto. ¿De verdad que no hay cosas más importantes e interesantes en las que invertir el tiempo que dedicamos a investigar? ¿No será que hay personas que invierten su tiempo en publicar (con protocolos que no pueden ser más estrictos y rigurosos, dicho sea de paso) para resolver problemas concretos de la práctica del entrenamiento deportivo, y avanzar así en nuestro conocimiento, y otras que simplemente publican por publicar (para agrandar “artificialmente” y llenar de paja su currículo académico)?

También otra parte del texto hace referencia a una cuestión que es muy utilizada también por parte de ciertos sectores o grupos de "especialistas", en los que se aboga por considerar la variable de "velocidad media" frente a la de "velocidad media propulsiva" como indicadores más fiables para la valoración y el control del entrenamiento de la fuerza. Siendo conscientes de que, en el caso del salto, podría ser más recomendable considerar la velocidad pico ¿Podría aclarar y justificar por qué para usted son los valores promedio de velocidad de la fase propulsiva del movimiento (VMP) los que deben ser considerados para la evaluación del efecto del entrenamiento de la fuerza, y si puede existir algún caso que no fuera así?

Esto es más de lo mismo. Otro ejemplo de querer “buscarle tres pies al gato” y de la ignorancia de algunos advenedizos y oportunistas. Ambas variables pueden utilizarse. En general, la VMP es preferible a la VM porque expresa mejor el potencial neuromuscular del sujeto ante cargas ligeras y medias (a menor carga, mayor será la diferencia entre la VMP y la VM). Cuando la carga es suficientemente grande, ambas variables se igualan porque no existe fase final de frenado. Así de simple. Todo esto está perfectamente descrito (Sánchez-Medina et al., 2010) y ¡¡ no tiene nada que ver con la fiabilidad !!. En ningún estudio hemos dicho que la VMP sea más o menos fiable que la VM. Son cosas independientes que nunca hemos relacionado. Cuando se mide con los instrumentos adecuados y con protocolos de evaluación correctos y rigurosos, ambas variables, VM y VMP, son altamente fiables, con un coeficiente de correlación intraclase (CCI) muy próximo a 1 (coeficiente, dicho sea de paso, que no pocos investigadores en nuestro campo calculan incorrectamente en sus estudios).

Aquí es necesario puntualizar que para poder medir la VMP, lo cual recomendamos porque esta variable permite valorar mejor el efecto del entrenamiento, es necesario disponer de un dispositivo capaz de medirla. En nuestro caso empleamos el T-FORCE System, un instrumento que desarrollamos (y hemos ido mejorando) hace ya 10 años por la necesidad que teníamos de medir correctamente. Si el instrumento de medida no permite determinar la VMP (normalmente por carecer de una elevada frecuencia de muestreo), habrá que emplear la VM. No hay más misterio.

Por último, en el caso del salto vertical, la velocidad pico o máxima de la fase concéntrica (VMax), que se alcanza pocos milisegundos antes del despegue del suelo, es la variable más indicada pues es la que refleja mejor el rendimiento del deportista y es mucho más reproducible (ahora sí hablamos de fiabilidad) –siempre que se mida correctamente– que el tiempo de vuelo que se ve muy afectado por cómo apoya el sujeto los pies a la hora de aterrizar.

La aparición y rápido desarrollo de la tecnología portátil ha irrumpido con fuerza en los últimos años en el ámbito del entrenamiento (incluso llegando al ámbito “científico”). Concretamente, se han desarrollado numerosos dispositivos (acelerómetros, aplicaciones móviles, etc.) diseñados para medir la velocidad de ejecución y poder estimar la 1RM a partir de las velocidades medias de un test incremental con cargas. Además, algunos de estos dispositivos han quedado supuestamente “avalados” por determinados estudios científicos de validación concurrente y fiabilidad. ¿Qué opinión le merece este tipo de dispositivos sobre los que, como indicamos, incluso se pueden encontrar publicaciones?

Efectivamente, gracias al incesante avance de la tecnología estamos asistiendo a un “boom” en la aparición de dispositivos en el mercado que pretenden medir todo tipo de variables relacionadas con el rendimiento deportivo (en el ámbito del entrenamiento de fuerza y en muchos otros). Esto es muy positivo, siempre que dichos dispositivos proporcionen datos correctos (precisos y reproducibles, y por tanto válidos). Desafortunadamente, muchos de ellos son puro marketing y cometen errores del todo inadmisibles para poder ser utilizados en la evaluación periódica y/o la monitorización diaria del rendimiento de los deportistas. Sería fantástico (y yo estaría encantado) de que hubiera un dispositivo (pequeño y ligero, inalámbrico, ágil y sencillo de usar) que por 100-200 euros nos proporcionase datos precisos de velocidad durante el entrenamiento. A día de hoy aún no lo he encontrado. Pero todo llegará.

Hay que examinar, uno por uno, los dispositivos que hay en el mercado para poder concluir si verdaderamente son útiles o no, ya que hay algunos que miden muy bien, otros cometen errores importantes, y otros que son un auténtico desastre. A este respecto recomiendo la lectura de la carta “Wearable, yes, but able…?: it is time for evidence-based marketing claims!” de Sperlich & Holmberg (2017).

Nosotros podemos comprobar a diario cómo, en deportistas de élite, diferencias de velocidad de tan solo 0,02-0,03 m/s ante una determinada carga pueden ser ya indicadoras de cambios en su rendimiento competitivo. También sabemos que cada 5% de 1RM de incremento de carga lleva asociado una diferencia de velocidad (VMP, por ejemplo) de 0,07-0,09 m/s (según el ejercicio). Si empleamos un dispositivo cuyo error de medida ya es de más de 1 décima de metro por segundo (a menudo hasta 0,20 y 0,30 m/s), ¿para qué nos va a servir? No va a ser capaz de discriminar cambios en el rendimiento neuromuscular del deportista.

Y pondré un ejemplo: el caso del dispositivo “Beast”. Si funcionase sería magnífico pero es un caso de marketing 100%, algo incapaz de medir correctamente. El resultado: un dispositivo muy atractivo (pero inservible) que es una verdadera estafa para el consumidor. Creo que con una simple gráfica podemos hacernos una idea de la precisión de dicho “instrumento”:

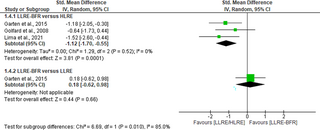

Figura 1. Acuerdo entre las medidas de dos unidades T-FORCE (izquierda) y una unidad T-FORCE (eje X) y una unidad Beast (eje Y) (derecha) en los ejercicios de sentadilla completa y press de banca (datos de un estudio recién terminado). Los valores corresponden a la velocidad media (VM) de la fase concéntrica de cada ejercicio. La línea de identidad (y = x) se indica en color gris claro.

Actualmente estamos terminando dos estudios muy completos que comparan diferentes instrumentos de medida de la velocidad de ejecución (transductores lineales de posición o velocidad por cable, dispositivos basados en acelerometría, dispositivos optoelectrónicos y alguna “app” para móvil). Pronto estaremos en condiciones de publicar y divulgar los resultados.

Respecto a que haya artículos publicados en revistas científicas que supuestamente “validen” algunos de estos sistemas sólo puedo decir que hoy en día, y cada vez más, se publican muchos estudios que carecen de rigor. En mi opinión, menos del 15% de lo que se publica actualmente en nuestro campo es de interés y aplicabilidad real al entrenamiento y cumple unos criterios de calidad científica. El que algo se publique no lo convierte en un “dogma”. Si bien es cierto que hay grupos de investigación serios que publican cosas de gran valor e interés, que contribuyen a mejorar nuestro conocimiento de las respuestas y adaptaciones al entrenamiento y a mejorar el rendimiento de nuestros deportistas (no hay que olvidar que hacemos investigación aplicada y éste debería ser el objetivo final), no es menos cierto que cada vez es más difícil discernir el grano entre tanta paja.

Cuando te pones a “destripar” muchas publicaciones se hacen patentes errores de todo tipo (conceptuales, metodológicos, de análisis, etc.) e, incluso en ocasiones, manipulaciones o “fabricación de datos”. Esto no es más que un reflejo de la mediocridad y la corrupción que impera en nuestra sociedad. No hay más que ir a la biblioteca y echar la vista atrás a artículos de los años 70, 80, 90 e incluso mucho antes. Se publicaba menos cantidad, pero de muchísima más calidad que ahora. ¿Qué hace falta para publicar un artículo? Que dos revisores (a lo sumo tres e incluso, a veces, uno solo que suele ser el propio editor de la revista) le den su aprobación; revisores que en muchos casos no tienen conocimiento suficiente sobre el tema que se trata, son amigos de quien publica o tienen intereses comunes, o esperan que se les devuelva el favor, etc. Hay muchos intereses creados y auténticas mafias en este campo. También están los intereses comerciales (algo que, por ejemplo, en el campo de la medicina, siempre ha ocurrido con el caso de las farmacéuticas), por no hablar de cuestiones éticas. No hay revisores suficientes para dar a basto con la cantidad de publicaciones y revistas disponibles actualmente (que no deja de aumentar). Esta “avalancha” de journals y publicaciones estaría bien si existieran los filtros de calidad adecuados; pero no los hay. Yo mismo he revisado y rechazados artículos que hacían agua por todos lados para verlos luego publicados, a las pocas semanas, en otra revista sin corregir ni una coma. La gente prueba… ¡en algún sitio colará! Este es un problema gravísimo que existe actualmente. Al respecto podría contar al menos una decena de historias, pero son demasiado tristes y no es mi intención desilusionar a los que trabajan de forma coherente y rigurosa. Parte del problema es que cualquier publicación que es aceptada (aunque contenga errores importantes) suma y agranda el currículum del investigador, cuando lo que debería hacer es restarle méritos si contiene errores o falsedades importantes. Desafortunadamente, este un problema que no creo que tenga solución.

Pongamos otro ejemplo: el “Myotest”. Un dispositivo también basado en acelerometría que salió hace ya varios años. Enseguida surgieron al menos 3 ó 4 publicaciones (supuestamente científicas) que lo validaban. En los Estados Unidos se hizo una campaña publicitaria muy fuerte para promocionarlo. La propia NSCA lo anunciaba en su página web. Nosotros lo compramos y lo probamos (como hemos hecho con el “Beast”, el “PUSH”, etc.). El error en las mediciones era escandaloso, pero resulta que estaba “validado”. ¿Quién usa hoy este dispositivo?

Para que nos entendamos, y poniendo un burdo símil: si yo peso 80 kg; me subo 5 veces consecutivas a una báscula y obtengo las medidas: 67 kg, 92 kg, 100 kg, 84 kg, 78 kg. ¿Se “fiaría” y compraría vd. dicha báscula? Errores de este calibre son habituales con algunos de los dispositivos a los que hacemos mención aquí. Como dice el refrán, “no hay peor ciego que el que no quiere ver”.

De esta forma ¿qué errores de tipo metodológico, estadístico, o de otro tipo, más relevantes considera se puedan estar cometiendo con las publicaciones científicas más recientes que tratan sobre la determinación de la relación carga-velocidad en distintos ejercicios, nivel de rendimiento u otras variables?

Hay errores de todo tipo. Pueden ser debidos a unos protocolos de medición y/o técnica de ejecución de los ejercicios incorrecta, a la elección de las variables inadecuadas, a la utilización de instrumentos de medida que no miden (valga la redundancia) correctamente, a un mal empleo de las pruebas estadísticas, etc. Muchos se deben al desconocimiento del propio concepto de validez. A veces se hace el promedio de la velocidad conseguida en varias repeticiones ante la misma carga en vez de tratar cada repetición individualmente… Muchas veces se eligen cargas que, como ya hemos comentado, no cubren todo el espectro posible de velocidades (desde muy rápidas a muy lentas). En el caso de los análisis de fiabilidad, como también acabamos de indicar, no se suele decir cómo se calcula el CCI; cosa que es fundamental describir en detalle (Koo & Li, 2016). El CCI a menudo se calcula incorrectamente, de la forma que más conviene al investigador, “inflando” así su valor. También muchos desconocen, olvidan o no quieren ver que la fiabilidad (reproducibilidad de la medida) es un requisito indispensable para que un instrumento pueda considerarse válido. Si un instrumento no es fiable nunca podrá ser válido. La validez es más que la existencia de una relación alta entre dos variables (un coeficiente “r” alto); el acuerdo entre dos medidores al medir la misma realidad debe ser muy alto (lo que implica un mínimo error en las medidas).

Entrevista a Luis Sánchez Medina, a propósito de la publicación de la Carta al Editor de Naclerio & Larumbe-Zabala (2018) y respuesta asociada (Sánchez-Medina et al., 2018) en la revista Sports Medicine International Open.

Ambas publicaciones son de acceso libre y gratuito y están disponibles (en inglés) en:

https://www.thieme-connect.com/products/ejournals/issue/10.1055/s-007-35335

Luis Sánchez es doctor en Ciencias de la Actividad Física y del Deporte y especialista en Alto Rendimiento Deportivo; es el creador del T-FORCE System, un instrumento para la evaluación y el control del entrenamiento de fuerza. Actualmente trabaja como Técnico Superior de Deportes en la Unidad de Asistencia al Deportista del Centro de Estudios, Investigación y Medicina del Deporte (CEIMD) del Gobierno de Navarra, en Pamplona. Es coautor, junto con Juan José González Badillo, Fernando Pareja y David Rodríguez, del libro “La velocidad de ejecución como referencia para la programación, control y evaluación del entrenamiento de fuerza” (2017), texto disponible en:

https://www.libreriadeportiva.com/libro/la-velocidad-de-ejecucion-como-referencia-para-la-programacion-control-y-evaluacion-del-entrenamiento-de-fuerza_71043

Así como, en su versión en inglés, en: http://www.vbtraining.net/index.html

Tal como vemos en la carta al editor, pero siendo algo que también podemos encontrar en algunos foros divulgativos y “científicos”, se intenta cuestionar la fiabilidad de las ecuaciones de regresión lineal utilizadas para la estimación de la 1RM que su grupo publicó en el año 2010 y en adelante para los ejercicios de press banca y squat. Aunque en la carta podemos encontrar una clara y contundente respuesta ¿qué podría añadirse para todos aquellos que se encuentren con algunas afirmaciones que cuestionen estas fórmulas?

En primer lugar creo que hay que aclarar que una ecuación lineal (y = ax + b) no es más que un caso particular de una ecuación polinómica de segundo grado (y = ax2 + bx + c) donde el factor “a” es cero. Una ecuación de segundo grado es una parábola, una curva. La relación fuerza-velocidad en el músculo responde mejor a una curva que a una línea recta, como está descrito desde hace décadas en los textos de fisiología muscular y del ejercicio. Dicho esto, en nuestros estudios hemos empleado ecuaciones de ajuste cuadráticas porque la mayoría de las veces dichas funciones ajustaban mejor a las parejas de datos carga-velocidad (ya sea velocidad media –VM– o velocidad media de la fase propulsiva –VMP–). Así lo han indicado los tests estadísticos realizados. Por ejemplo, en el artículo pionero realizado con el ejercicio de press banca (González-Badillo & Sánchez-Medina, 2010), el modelo preferido para ajustar los datos carga-velocidad (1596 pares de datos) fue el cuadrático, tanto para la VM como para la VMP. Es cierto que el coeficiente “a” es de una magnitud muy pequeña (lo cual indica una pequeña curvatura) pero ¿por qué no emplear un ajuste cuadrático si es el que mejor refleja la realidad medida? A lo largo de los últimos años hemos realizado miles de tests progresivos con cargas en numerosos ejercicios de entrenamiento de fuerza; en la inmensa mayoría de los casos el ajuste cuadrático es algo superior al lineal. No hay que darle más vueltas.

En el estudio de la sentadilla al que hace referencia esta carta al editor (Sánchez-Medina et al., 2017), el coeficiente de determinación (R2) medio de los 80 tests progresivos con cargas analizados fue de 0,995 tanto para la VM como para la VMP, con un error típico de estimación inferior a 0,06 m/s. Esto roza la perfección, cosa que, en una disciplina como las Ciencias del Deporte, creo que lo dice todo. No se puede hilar más fino. Además de estas consideraciones, lo más importante es que las ecuaciones publicadas por nuestro grupo vienen siendo utilizadas desde hace años en la práctica del entrenamiento de fuerza por muchísimos deportistas y, día tras día, la realidad y la experiencia empírica confirma su validez.

Puede ocurrir que cuando se mide la velocidad conseguida antes pocas cargas (por ejemplo, sólo de 3 a 5) que no cubren del todo el posible espectro de cargas (desde las muy ligeras hasta las muy altas), una ecuación lineal se ajuste también muy bien a los datos. Las diferencias son muy pequeñas y no tienen mayor importancia (aunque parece que algunos han visto aquí una oportunidad para la discusión y el debate).

Personalmente, me parece, por tanto, una cuestión estéril ahondar más en este punto. ¿De verdad que no hay cosas más importantes e interesantes en las que invertir el tiempo que dedicamos a investigar? ¿No será que hay personas que invierten su tiempo en publicar (con protocolos que no pueden ser más estrictos y rigurosos, dicho sea de paso) para resolver problemas concretos de la práctica del entrenamiento deportivo, y avanzar así en nuestro conocimiento, y otras que simplemente publican por publicar (para agrandar “artificialmente” y llenar de paja su currículo académico)?

También otra parte del texto hace referencia a una cuestión que es muy utilizada también por parte de ciertos sectores o grupos de "especialistas", en los que se aboga por considerar la variable de "velocidad media" frente a la de "velocidad media propulsiva" como indicadores más fiables para la valoración y el control del entrenamiento de la fuerza. Siendo conscientes de que, en el caso del salto, podría ser más recomendable considerar la velocidad pico ¿Podría aclarar y justificar por qué para usted son los valores promedio de velocidad de la fase propulsiva del movimiento (VMP) los que deben ser considerados para la evaluación del efecto del entrenamiento de la fuerza, y si puede existir algún caso que no fuera así?

Esto es más de lo mismo. Otro ejemplo de querer “buscarle tres pies al gato” y de la ignorancia de algunos advenedizos y oportunistas. Ambas variables pueden utilizarse. En general, la VMP es preferible a la VM porque expresa mejor el potencial neuromuscular del sujeto ante cargas ligeras y medias (a menor carga, mayor será la diferencia entre la VMP y la VM). Cuando la carga es suficientemente grande, ambas variables se igualan porque no existe fase final de frenado. Así de simple. Todo esto está perfectamente descrito (Sánchez-Medina et al., 2010) y ¡¡ no tiene nada que ver con la fiabilidad !!. En ningún estudio hemos dicho que la VMP sea más o menos fiable que la VM. Son cosas independientes que nunca hemos relacionado. Cuando se mide con los instrumentos adecuados y con protocolos de evaluación correctos y rigurosos, ambas variables, VM y VMP, son altamente fiables, con un coeficiente de correlación intraclase (CCI) muy próximo a 1 (coeficiente, dicho sea de paso, que no pocos investigadores en nuestro campo calculan incorrectamente en sus estudios).

Aquí es necesario puntualizar que para poder medir la VMP, lo cual recomendamos porque esta variable permite valorar mejor el efecto del entrenamiento, es necesario disponer de un dispositivo capaz de medirla. En nuestro caso empleamos el T-FORCE System, un instrumento que desarrollamos (y hemos ido mejorando) hace ya 10 años por la necesidad que teníamos de medir correctamente. Si el instrumento de medida no permite determinar la VMP (normalmente por carecer de una elevada frecuencia de muestreo), habrá que emplear la VM. No hay más misterio.

Por último, en el caso del salto vertical, la velocidad pico o máxima de la fase concéntrica (VMax), que se alcanza pocos milisegundos antes del despegue del suelo, es la variable más indicada pues es la que refleja mejor el rendimiento del deportista y es mucho más reproducible (ahora sí hablamos de fiabilidad) –siempre que se mida correctamente– que el tiempo de vuelo que se ve muy afectado por cómo apoya el sujeto los pies a la hora de aterrizar.

La aparición y rápido desarrollo de la tecnología portátil ha irrumpido con fuerza en los últimos años en el ámbito del entrenamiento (incluso llegando al ámbito “científico”). Concretamente, se han desarrollado numerosos dispositivos (acelerómetros, aplicaciones móviles, etc.) diseñados para medir la velocidad de ejecución y poder estimar la 1RM a partir de las velocidades medias de un test incremental con cargas. Además, algunos de estos dispositivos han quedado supuestamente “avalados” por determinados estudios científicos de validación concurrente y fiabilidad. ¿Qué opinión le merece este tipo de dispositivos sobre los que, como indicamos, incluso se pueden encontrar publicaciones?

Efectivamente, gracias al incesante avance de la tecnología estamos asistiendo a un “boom” en la aparición de dispositivos en el mercado que pretenden medir todo tipo de variables relacionadas con el rendimiento deportivo (en el ámbito del entrenamiento de fuerza y en muchos otros). Esto es muy positivo, siempre que dichos dispositivos proporcionen datos correctos (precisos y reproducibles, y por tanto válidos). Desafortunadamente, muchos de ellos son puro marketing y cometen errores del todo inadmisibles para poder ser utilizados en la evaluación periódica y/o la monitorización diaria del rendimiento de los deportistas. Sería fantástico (y yo estaría encantado) de que hubiera un dispositivo (pequeño y ligero, inalámbrico, ágil y sencillo de usar) que por 100-200 euros nos proporcionase datos precisos de velocidad durante el entrenamiento. A día de hoy aún no lo he encontrado. Pero todo llegará.

Hay que examinar, uno por uno, los dispositivos que hay en el mercado para poder concluir si verdaderamente son útiles o no, ya que hay algunos que miden muy bien, otros cometen errores importantes, y otros que son un auténtico desastre. A este respecto recomiendo la lectura de la carta “Wearable, yes, but able…?: it is time for evidence-based marketing claims!” de Sperlich & Holmberg (2017).

Nosotros podemos comprobar a diario cómo, en deportistas de élite, diferencias de velocidad de tan solo 0,02-0,03 m/s ante una determinada carga pueden ser ya indicadoras de cambios en su rendimiento competitivo. También sabemos que cada 5% de 1RM de incremento de carga lleva asociado una diferencia de velocidad (VMP, por ejemplo) de 0,07-0,09 m/s (según el ejercicio). Si empleamos un dispositivo cuyo error de medida ya es de más de 1 décima de metro por segundo (a menudo hasta 0,20 y 0,30 m/s), ¿para qué nos va a servir? No va a ser capaz de discriminar cambios en el rendimiento neuromuscular del deportista.

Y pondré un ejemplo: el caso del dispositivo “Beast”. Si funcionase sería magnífico pero es un caso de marketing 100%, algo incapaz de medir correctamente. El resultado: un dispositivo muy atractivo (pero inservible) que es una verdadera estafa para el consumidor. Creo que con una simple gráfica podemos hacernos una idea de la precisión de dicho “instrumento”:

Figura 1. Acuerdo entre las medidas de dos unidades T-FORCE (izquierda) y una unidad T-FORCE (eje X) y una unidad Beast (eje Y) (derecha) en los ejercicios de sentadilla completa y press de banca (datos de un estudio recién terminado). Los valores corresponden a la velocidad media (VM) de la fase concéntrica de cada ejercicio. La línea de identidad (y = x) se indica en color gris claro.

Actualmente estamos terminando dos estudios muy completos que comparan diferentes instrumentos de medida de la velocidad de ejecución (transductores lineales de posición o velocidad por cable, dispositivos basados en acelerometría, dispositivos optoelectrónicos y alguna “app” para móvil). Pronto estaremos en condiciones de publicar y divulgar los resultados.

Respecto a que haya artículos publicados en revistas científicas que supuestamente “validen” algunos de estos sistemas sólo puedo decir que hoy en día, y cada vez más, se publican muchos estudios que carecen de rigor. En mi opinión, menos del 15% de lo que se publica actualmente en nuestro campo es de interés y aplicabilidad real al entrenamiento y cumple unos criterios de calidad científica. El que algo se publique no lo convierte en un “dogma”. Si bien es cierto que hay grupos de investigación serios que publican cosas de gran valor e interés, que contribuyen a mejorar nuestro conocimiento de las respuestas y adaptaciones al entrenamiento y a mejorar el rendimiento de nuestros deportistas (no hay que olvidar que hacemos investigación aplicada y éste debería ser el objetivo final), no es menos cierto que cada vez es más difícil discernir el grano entre tanta paja.

Cuando te pones a “destripar” muchas publicaciones se hacen patentes errores de todo tipo (conceptuales, metodológicos, de análisis, etc.) e, incluso en ocasiones, manipulaciones o “fabricación de datos”. Esto no es más que un reflejo de la mediocridad y la corrupción que impera en nuestra sociedad. No hay más que ir a la biblioteca y echar la vista atrás a artículos de los años 70, 80, 90 e incluso mucho antes. Se publicaba menos cantidad, pero de muchísima más calidad que ahora. ¿Qué hace falta para publicar un artículo? Que dos revisores (a lo sumo tres e incluso, a veces, uno solo que suele ser el propio editor de la revista) le den su aprobación; revisores que en muchos casos no tienen conocimiento suficiente sobre el tema que se trata, son amigos de quien publica o tienen intereses comunes, o esperan que se les devuelva el favor, etc. Hay muchos intereses creados y auténticas mafias en este campo. También están los intereses comerciales (algo que, por ejemplo, en el campo de la medicina, siempre ha ocurrido con el caso de las farmacéuticas), por no hablar de cuestiones éticas. No hay revisores suficientes para dar a basto con la cantidad de publicaciones y revistas disponibles actualmente (que no deja de aumentar). Esta “avalancha” de journals y publicaciones estaría bien si existieran los filtros de calidad adecuados; pero no los hay. Yo mismo he revisado y rechazados artículos que hacían agua por todos lados para verlos luego publicados, a las pocas semanas, en otra revista sin corregir ni una coma. La gente prueba… ¡en algún sitio colará! Este es un problema gravísimo que existe actualmente. Al respecto podría contar al menos una decena de historias, pero son demasiado tristes y no es mi intención desilusionar a los que trabajan de forma coherente y rigurosa. Parte del problema es que cualquier publicación que es aceptada (aunque contenga errores importantes) suma y agranda el currículum del investigador, cuando lo que debería hacer es restarle méritos si contiene errores o falsedades importantes. Desafortunadamente, este un problema que no creo que tenga solución.

Pongamos otro ejemplo: el “Myotest”. Un dispositivo también basado en acelerometría que salió hace ya varios años. Enseguida surgieron al menos 3 ó 4 publicaciones (supuestamente científicas) que lo validaban. En los Estados Unidos se hizo una campaña publicitaria muy fuerte para promocionarlo. La propia NSCA lo anunciaba en su página web. Nosotros lo compramos y lo probamos (como hemos hecho con el “Beast”, el “PUSH”, etc.). El error en las mediciones era escandaloso, pero resulta que estaba “validado”. ¿Quién usa hoy este dispositivo?

Para que nos entendamos, y poniendo un burdo símil: si yo peso 80 kg; me subo 5 veces consecutivas a una báscula y obtengo las medidas: 67 kg, 92 kg, 100 kg, 84 kg, 78 kg. ¿Se “fiaría” y compraría vd. dicha báscula? Errores de este calibre son habituales con algunos de los dispositivos a los que hacemos mención aquí. Como dice el refrán, “no hay peor ciego que el que no quiere ver”.

De esta forma ¿qué errores de tipo metodológico, estadístico, o de otro tipo, más relevantes considera se puedan estar cometiendo con las publicaciones científicas más recientes que tratan sobre la determinación de la relación carga-velocidad en distintos ejercicios, nivel de rendimiento u otras variables?

Hay errores de todo tipo. Pueden ser debidos a unos protocolos de medición y/o técnica de ejecución de los ejercicios incorrecta, a la elección de las variables inadecuadas, a la utilización de instrumentos de medida que no miden (valga la redundancia) correctamente, a un mal empleo de las pruebas estadísticas, etc. Muchos se deben al desconocimiento del propio concepto de validez. A veces se hace el promedio de la velocidad conseguida en varias repeticiones ante la misma carga en vez de tratar cada repetición individualmente… Muchas veces se eligen cargas que, como ya hemos comentado, no cubren todo el espectro posible de velocidades (desde muy rápidas a muy lentas). En el caso de los análisis de fiabilidad, como también acabamos de indicar, no se suele decir cómo se calcula el CCI; cosa que es fundamental describir en detalle (Koo & Li, 2016). El CCI a menudo se calcula incorrectamente, de la forma que más conviene al investigador, “inflando” así su valor. También muchos desconocen, olvidan o no quieren ver que la fiabilidad (reproducibilidad de la medida) es un requisito indispensable para que un instrumento pueda considerarse válido. Si un instrumento no es fiable nunca podrá ser válido. La validez es más que la existencia de una relación alta entre dos variables (un coeficiente “r” alto); el acuerdo entre dos medidores al medir la misma realidad debe ser muy alto (lo que implica un mínimo error en las medidas).

REFERENCIAS

1. González Badillo JJ, Sánchez Medina L (2010). Movement velocity as a measure of loading intensity in resistance training. Int J Sports Med 31(5): 347-352

2. Koo TK, Li MY (2016). A guideline of selecting and reporting intraclass correlation coefficients for reliability research. J Chiropractic Med 15, 155-163

3. Sánchez Medina L, Pallarés JG, Pérez CE, Morán Navarro R, González Badillo JJ (2017). Estimation of relative load from bar velocity in the full back squat exercise. Sports Med Int Open 1(2): E80-E88

4. Sánchez Medina L, Pérez CE, González Badillo JJ (2010). Importance of the propulsive phase in strength assessment. Int J Sports Med 31(2): 123-129

5. Sperlich B, Holmberg HC (2017). Wearable, yes, but able…?: it is time for evidence-based marketing claims! Br J Sports Med 51(16):1240.

Efecto agudo del ejercicio de resistencia de baja carga con restricción del flujo sanguíneo sobre los biomarcadores de estrés oxidativo: una revisión sistemática y un metanálisis

Resumen Fondo El propósito de esta revisión fue analizar los efectos agudos del ejercicio de...

Efectos del entrenamiento de swing con pesas rusas sobre la demanda cardiorrespiratoria y metabólica en una competición simulada en jóvenes gimnastas artísticas

ResumenExaminamos los efectos de agregar un programa de entrenamiento de Kettlebell Swing (KB) al...

Efectos y limitaciones del ejercicio de control motor en el hogar para el dolor lumbar crónico: un estudio prospectivo de un solo centro

Resumen Diseño del estudio Estudio observacional prospectivo unicéntrico. Objetivo Investigar los...

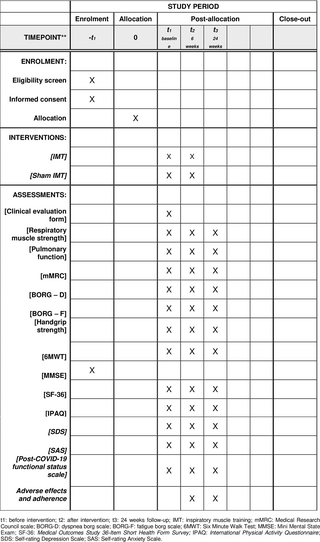

Eficacia del entrenamiento de los músculos inspiratorios domiciliario en pacientes post-covid-19: protocolo para un ensayo clínico aleatorizado

Resumen Introducción La evidencia actual sugiere la aparición de un nuevo síndrome (síndrome de...

Estimación de la carga relativa a partir de la velocidad del movimiento en el ejercicio de press de pecho sentado en adultos mayores

Resumen Apuntar Este estudio tuvo como objetivo i) determinar la relación carga-velocidad en el...